Le 7 décembre dernier, les commissaires à la vie privée du Canada ont publié une déclaration concernant les principes pour des technologies de l’intelligence artificielle (IA) générative responsables, dignes de confiance et respectueuses de la vie privée. Ces derniers y mettent de l’avant les « considérations relatives à l’application des principes clés de protection de la vie privée aux technologies d’IA générative ».

Cette déclaration fait notamment suite à la déclaration commune sur les technologies d’IA générative des autorités du G7 en matière de protection des données et de la vie privée de juin 2023, la déclaration des autorités du G7 sur les Principes directeurs internationaux du processus Hiroshima pour les systèmes d’IA avancés (Statement on the Hiroshima AI Process) ainsi qu’à la résolution d’octobre 2023 sur les systèmes d’IA générative de l’Assemblée mondiale pour la protection de la vie privée. Une majorité des principes mis de l’avant dans ces précédentes déclarations y sont d’ailleurs repris.

Un concept en mouvance et des obligations à la source

« Nous reconnaissons que l’IA générative est un domaine émergent et que notre compréhension de celui-ci évoluera au fil du temps. Les commissaires fédéral, provinciaux et territoriaux à la protection de la vie privée du Canada continueront d’explorer ce sujet complexe et pourraient fournir des conseils ou d’autres ressources à mesure que nous en apprendrons davantage sur la technologie et ses risques, y compris à mesure que les enquêtes officielles liées à la technologie seront terminées. »

De manière similaire à la déclaration sur les principes directeurs internationaux du processus Hiroshima pour les systèmes d’IA, les commissaires à la vie privée reconnaissent que le phénomène des IA génératives est un concept nouveau et en mouvance qui nécessité une réévaluation continue des risques associés à son développement. Dans cette perspective, ils soulignent que les principes énoncés dans la déclaration « ne lient pas les enquêtes ou les décisions spécifiques des commissaires fédéral, provinciaux ou territoriaux à la protection de la vie privée du Canada […] ».

La déclaration cible deux types d’organisations distinctes concernées : les développeurs et fournisseurs, ainsi que les « organisations utilisant l’IA génératives ». Cette distinction est notable, car identifier des responsabilités spécifiques pour les développeurs et fournisseurs d’IA, même si une organisation peut assumer ces deux rôles, permet de potentiellement minimiser les risques liés à la protection des données dès leur origine. En plus de permettre « d’examiner l’application des principes de protection de la vie privée à de multiples éléments de l’écosystème de l’IA générative », tel que mentionné dans la déclaration.

Une vision globale des principes peu surprenante, mais complète

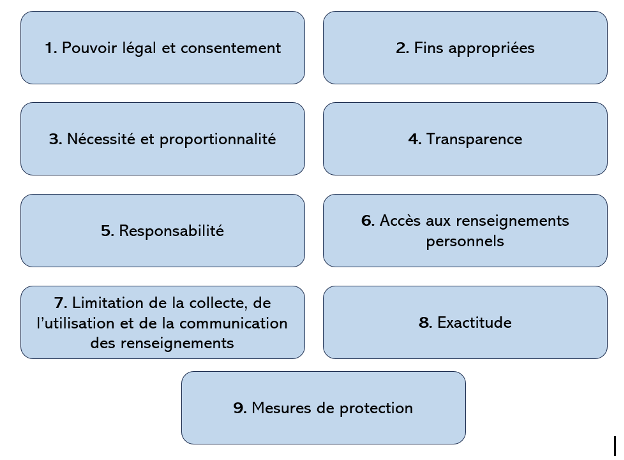

Les principes sont structurés en neuf parties distinctes:

Bien qu’ils ne soient pas contraignants, ces principes « mettent l’accent sur les lois et les règlements sur la protection de la vie privée, et sur la façon dont ils peuvent s’appliquer aux organisations ». Force est de conster qu’au Québec, presque tous les principes énumérés dans la directive peuvent être rattachés à une obligation légale, que ce soit à travers les Chartes ou les diverses lois sur la protection des renseignements personnels (Voir entre autres la Charte québécoise, la loi de protection des renseignements personnels dans le domaine privé et le domaine public). Notamment les dispositions entourant la collecte, l’utilisation primaire ou secondaire, la communication, la conservation, l’accès et le droit de rectifications des renseignements personnels, mais aussi les nouvelles dispositions concernant l’explicabilité et la transparence des IA décisionnelles (décisions automatisées).

« Ne pas développer ou mettre en service des systèmes d’IA générative qui violent des « zones interdites », comme le profilage qui peut mener à un traitement injuste, contraire à l’éthique ou discriminatoire […]

indiquer clairement à toute partie concernée si un outil d’IA générative sera utilisé dans le cadre d’un processus décisionnel et, le cas échéant, à quel titre et avec quelles mesures de protection, ainsi que les options ou recours à la disposition de la partie touchée (particulièrement lorsqu’une décision peut avoir une incidence importante sur une personne). Cette explication doit également comprendre une description générale du fonctionnement du système, la façon dont il est utilisé pour prendre une décision ou une mesure, et un aperçu des résultats possibles;

savoir que la responsabilité des décisions incombe à l’organisation et non à tout type de système automatisé utilisé pour appuyer le processus décisionnel;

veiller à ce que les personnes touchées disposent d’un mécanisme de contestation efficace pour toute décision administrative ou autre décision importante prise à leur sujet. »

Nous pouvons penser que ces principes trouvent application dans le cas des décisions fondées exclusivement sur un traitement automatisé (art. 12.1 loi sur le privé et 65.2 loi sur le public). À ce sujet, il est intéressant de noter que certains principes émis par les commissaires dans cette directive témoignent d’une prise de conscience à l’effet que pas toutes les intelligences artificielles génératives peuvent être « expliquées » :

« prendre les mesures requises pour que les résultats des systèmes d’IA générative soient traçables et explicables. En résumé, il s’agit de faire un compte rendu complet du fonctionnement du système (traçabilité) et de présenter une justification de la façon dont un extrant a été obtenu. Lorsqu’un développeur ou un fournisseur est d’avis que les résultats d’un outil d’IA générative ne sont pas explicables, ce fait doit être communiqué explicitement à toute organisation qui utilise l’outil ou à toute personne interagissant avec l’outil pour lui permettre de déterminer si ce dernier convient aux fins prévues.

si les résultats d’un système d’IA générative ne sont pas explicables de façon claire, déterminer si l’utilisation proposée est appropriée. » [Nos soulignements]

Ainsi, bien que la directive mette de l’avant des principes de transparence et d’explicabilité, les commissaires reconnaissent la possibilité d’avoir recours à une IA pour laquelle il est impossible d’en expliquer les résultats, sous la condition d’évaluer l’utilisation proposée.

Quelques principes intéressants

Sans surprise, les pouvoirs légaux et le consentement (assises légales) font partie des principes énoncés. Il est cependant pertinent de soulever le principe voulant que les renseignements personnels inférés par l’IA demeurent visés par les obligations liées à la collecte et nécessitent aussi une assise légale:

« se rappeler que l’inférence d’information au sujet d’une personne identifiable (comme les extrants sur une personne provenant d’un système d’IA générative) sera considérée comme une collecte de renseignements personnels et, par conséquent, nécessiterait une assise légale la permettant; »

Un principe qui a d’ailleurs été au centre d’une décision rendue par la CAI à l’automne 2022.

Dans la deuxième section concernant les « fins appropriées », les commissaires abordent la question des zones interdites émergentes potentielles en lien avec l’utilisation de l’IA générative :

« Des décisions sur la légalité de certaines pratiques – par exemple à la suite d’enquêtes ou de conclusions de droit – n’ont pas encore été rendues dans le contexte de l’IA générative, et les commissaires fédéral, provinciaux ou territoriaux à la protection de la vie privée du Canada n’ont pas non plus émis de positions de principe sur les zones interdites de l’IA générative.

Toutefois, nous prévoyons (sans lier les futures enquêtes, conclusions juridiques ou positions de principe contraignantes) que de telles zones interdites pourraient comprendre des objectifs comme:

- la création de contenu d’IA (y compris des hypertrucages) à des fins malveillantes, comme contourner un système d’authentification ou générer des images intimes d’une personne identifiable sans son consentement;

- l’utilisation de robots conversationnels pour inciter délibérément des personnes à communiquer des renseignements personnels (et, en particulier, des renseignements personnels de nature sensible) qu’elles n’auraient pas autrement communiqués;

- la production et la publication de renseignements faux ou diffamatoires au sujet d’une personne. »

Ces « potentielles zones interdites » identifiées par les commissaires sont intéressantes, en ce qu’elles concernent essentiellement la création ou la collecte de renseignements personnels à l’aide de l’IA et non le processus habituel inverse d’utilisation de renseignements personnels par une IA.

Similairement, le principe voulant « d’éviter de demander à un système d’IA générative de re-identifier toute donnée précédemment dépersonnalisée » vise lui aussi une IA faisant un processus inverse de reconstitution de renseignements identificatoires. Ce principe dégagé par les commissaires est d’autant plus intéressant lorsqu’analysé parallèlement à celui d’utiliser « des données anonymisées, synthétiques ou dépersonnalisées plutôt que des renseignements personnels ». En effet, bien qu’il soit préférable d’utiliser des données anonymisées ou dépersonnalisées afin de développer des IA, ce processus d’anonymisation et de dépersonnalisation sera aussi plus hasardeux en raison que cette même IA est en mesure de faire le processus inverse de réidentification. Un parallèle peut-il être dressé entre ce constat et une majorité des enjeux que pose l’IA?

Commentaires